最近,因工作需要,专研云的相关技术,从技术的金字塔模型来看,云算是技术链顶端。

这也就造就了,学习和使用的人不多,会的人都在大公司,可交流的人不多。也就是有难度才有挑战。

那我是如何开始学习的呢?

🔅 一万小时定律

著名的一万小时定律指的是在一个特定的领域刻意训练达到一定时间,就会变成这个领域的顶尖人材。

但我想说的是这个理论的另外一面,你永远不是从零开始,宇宙万物是彼此关联,在一个领域的经验往往在进入另一个领域时也同样生效。

这一点很重要,消除恐惧感,对学习而言是很有效的。

🔅 学习的方法

☼ 提前准备的资源

就开始搜索相关的资料,然后一并保存起来。形式零星的关键词记忆。

等有了一些基础知识时,再选一本这个领域的好书。我个人喜欢纸质书,因为这本书不是用来看的,而是一个归纳整理工具,这一点一会再讲到。

☼ 拼图理论

现代知识体系越来越趋于复杂化,像之前两三个做出一个小产品,到现在的动辄百人的开发团队协作,在云的相关技术更是这样,技术不再是单体,而是生态了。

那学习的方法也要跟得上,不然学到老也未必跟的上技术的迭代。

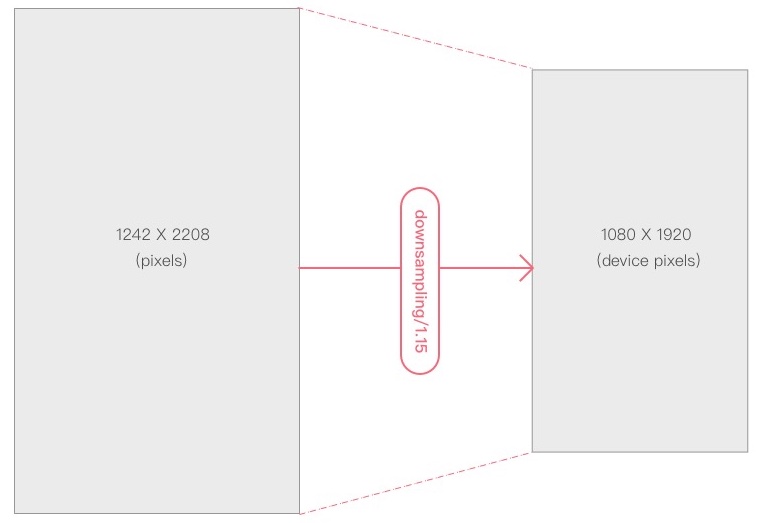

解决复杂性的方法有哪些呢,我个人用的一个叫拼图模型(也可以说是知识图谱)就是我把要学习的这个生态里的知识归类,做成拼图里的一个个小块,刚开始小块的边界很难划分,先不用太在意。在未来的时间里,这些块会趋向于完美。

当我们脑海中有这么一张拼图时(当然更建议用软件、笔把它画出来,这样更清晰),再看待一些东西,就会很清晰的知道它的位置、边界,重要性的定义,以及几样事物之前的关联。

而且更为重要的是,可以有区别的对待每一块的技术,在不周的时间上专研不同的块,还可以在某一个块不得要领时,换一个块去解决,为什么叫拼图理论,因为和拼图一样,有时你解决不了的一个地方,换去解决另一个地方,反而就把之前未能解决的问题给解决了。

当然,从管理学角度来看,这会引起另一个变革,清晰的块划分有利于分工合作。而合作带来整体效能的提升。

再回到刚提起的那本书,书的作用不再是细读,而是更快速的用前人总结好的知识体系,更快速的构建自己的知识架构拼图。

除了好书,构建拼图的好办法就是去听一些演讲,演讲从来都不能表达行为,都是用于概念的传播。听一个演讲就可以从别人的经验中完善自己的领域知识拼图。

☼ 学会排优先级

有了拼图模型,看着其中密密麻麻的块,这里最应该注意的是什么,是找到其中重要的点。

有些知识很重要,但可能在起步时反而用不到,有些是边边角角的技能反而是初始化的必要条件。

可以用管理学的重要和紧急二维模型,来给知识块进行优先级分类。

这样也可以大规模的降低启动的复杂度,合理的安排推进时间。

☼ 合作带来效能

有了拼图,划分清楚了边界,就有了合作的可能性。

然后,就是找到某些块的合作伙伴,或者在某个块上找到一些有经验的人、专家,迅速把这一个块给做掉。

比如说这次的学习中,有一个很大的块就是网络模型,这牵涉到很低层的网络知识体系,这一块就可以找到一个擅长网络的同事一起研究,于是两个人相互提升,扩充了自己的边界,也让事情的进展更快。

🔅 行动的力量

上面提到了很多学习的方法论,但技术的学习从来都不只是提升知识,而是多于实践,重于应用。

在本次中,一开始,就尝试着把 google / github 的代码去运行,计算机的好处就是永远可以低成本实践,对错永远分明。

为什么行动如此重要,因为别人的东西都不一定是对的,哪怕是最新的文章,都不一定能跑出正确的结果。要自己去多实践。

行动过程中的错误,更是一笔财富,无论是一本书,还是一篇文章,里面教的都是正确的路径,而如何解决错误,调试问题的能力则是行动过程中的最重要的。

毕竟理论和实践中总有那么一条鸿沟。

🔅 完成

在大的知识体系拼图的指引下,通过行动的力量,慢慢的,终于一嘬山一样的难题,就这样被解决了。

REF::